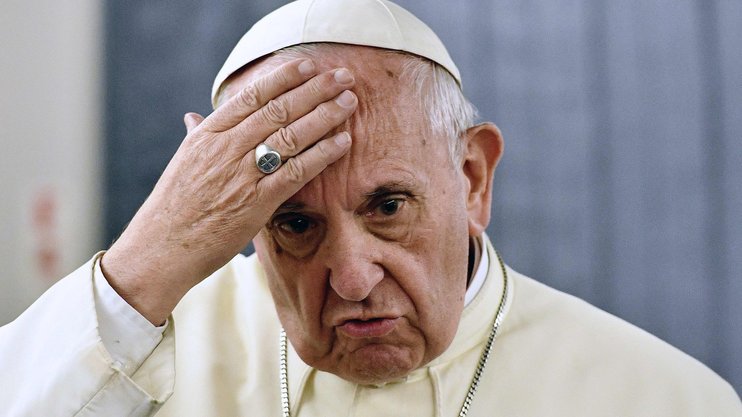

Папа Римский Франциск призвал техкомпании быть осторожными с развитием искусственного интеллекта. Он считает, что неправильный подход к технологиям может иметь очень неприятные последствия для всех людей.

В Ватикане прошла конференция с участием представителей компаний из Кремниевой долины, (в частности, Facebook, Mozilla и Western Digital) специалистов по компьютерным технологиям, католической этике, государственных органов и инвестиционных банков.

Материалы конференции будут использованы для подготовки папской энциклики — письма Папы Римского членам католической церкви — о технологиях искусственного интеллекта. В 2015 году после подобных встреч была издана известная энциклика Laudato Si, посвященная вопросам защиты окружающей среды и глобального потепления.

«Впечатляющие разработки в области технологий, особенно в сфере искусственного интеллекта, начинают оказывать все более существенное влияние на все сферы человеческой деятельности. Поэтому открытые и конкретные дискуссии на эту тему необходимы как никогда», - передает агентство Reuters слова Папы Римского.

Франциск считает, что компании должны быть более осторожными: «Если так называемый технический прогресс человечества станет врагом общего блага, это приведет к жалкой регрессии к форме варварства, диктуемой законом сильнейшего».

Папа Римский считает, что технологии нуждаются в теоретических и практических моральных принципах. В противном случае технология может быть использована в злонамеренных целях. Папа Франциск считает, что искусственный интеллект сможет «отравить» тему публичных дебатов, распространять ложные мнения и манипулировать миллионами людей одновременно. «Может даже существовать угроза учреждениям, которые должны гарантировать мирное сосуществование», - предупредил он.

Технологическим компаниям важно с самого начала разработки своих новых продуктов рассматривать вопросы их неэтичного использования и иметь у себя группы специалистов, занимающихся этими вопросами, отметил на открытии конференции первый помощник главного юрисконсульта компании Facebook Гэвин Корн.

Использование искусственного интеллекта, позволяющего боевым системам самостоятельно выбирать и атаковать цели, вызвало в последние годы этические споры. Критики предупредили, что это поставит под угрозу международную безопасность и ознаменует собой третью революцию в войне после пороха и атомной бомбы. К тому же рано или поздно автономные боевые системы попадут в руки террористов, которые смогут их с легкостью перепрограммировать на уничтожение других целей.

Amazon, Microsoft и Intel входят в число ведущих технологических компаний, подвергающих мир риску из-за разработки роботов-убийц, согласно отчету, в котором ведущие игроки отрасли высказались о своей позиции в отношении смертоносного автономного оружия.

Нидерландская неправительственная организация Pax классифицировала 50 компаний по трем критериям: разрабатывают ли они технологии, которые могут иметь отношение к смертоносному ИИ, работают ли они над соответствующими военными проектами и взяли ли на себя обязательство воздерживаться от участия в них в будущем.

В общей сложности 22 компании относились к категории "средней степени обеспокоенности", а 21 - к категории "высокой обеспокоенности", в частности Amazon и Microsoft, которые участвуют в тендере на поставку облачной инфраструктуры для армии США на сумму $10 млрд по контракту Пентагона.

К числу других компаний, входящих в группу высокого риска, относится компания Palantir, основанная при поддержке ЦРУ и получившая контракт на $800 млн на разработку системы искусственного интеллекта, "которая может помочь солдатам анализировать зону боевых действий в режиме реального времени".

Развитие искусственного интеллекта в военных целях вызвало дебаты и протесты в отрасли: в прошлом году Google отказалась продлить контракт с Пентагоном под названием Project Maven, который использовал машинное обучение для различения людей и объектов при использовании военных дронов.

В апреле Европейский союз опубликовал руководство о том, как компании и правительства должны разрабатывать ИИ, в том числе о необходимости человеческого контроля, недискриминационной работы в интересах общества и окружающей среды и соблюдения конфиденциальности. Все участники дискуссии опасаются, что дальнейшие разработки в этой сфере могут спровоцировать новую гонку вооружений. Эксперты убеждены, что машине нельзя доверять решение, будет ли человек жить или умрет.