Искусственный интеллект AlphaGo от Google и стартапа DeepMind обыграл практически всех ведущих игроков — 99,8% геймеров — в стратегию Starcraft II. Исследователи считают, что такие алгоритмы найдут применение в решении реальных проблем, но есть основания в этом сомневаться.

Инженеры компании DeepMind (с 2014 года — подразделение Google) недавно представили окончательную версию своей программы AlphaStar — искусственного интеллекта, способного играть в классическую стратегию StarCraft II. Еще в январе 2019 года AlphaStar играла на уровне продвинутых любителей, а сегодня усовершенствованный ИИ входит в высшие 0,2% игроков и на равных соперничает с лучшими из лучших.

AlphaStar — это наследница AlphaGo, программы, победившей человека в игру го. Лидером нового проекта стал Ориол Виньялс, который участвовал в разработках сервисов машинного перевода и распознавания речи для Google.

И в Google Brain, и в DeepMind занимаются, прежде всего, экспериментальными проектами без какой-либо непосредственной практической значимости. Помимо систем игрового ИИ, среди известных проектов DeepMind можно отметить систему нейросетевого синтеза речи WaveNet и начинания в области медицины — например, экспериментальную систему постановки диагноза по анализу изображений в офтальмологии.

Ученые выбрали для экспериментов игру потому, что стратегии в реальном времени, вроде игр из серии StarCraft, очень сложны для алгоритмов, которые могли бы в них играть. В каждый момент времени игрок видит не весь игровой мир целиком, а только его часть на карте, поэтому ему приходится ориентироваться на местности и постоянно принимать решения о следующем шаге. Поэтому обучение машин игре требует долгой упорной работы, большого количества данных, а также разработки сложных алгоритмов, которые могут решать все появляющиеся в игре задачи.

Ученые выбрали для экспериментов игру потому, что стратегии в реальном времени, вроде игр из серии StarCraft, очень сложны для алгоритмов, которые могли бы в них играть. В каждый момент времени игрок видит не весь игровой мир целиком, а только его часть на карте, поэтому ему приходится ориентироваться на местности и постоянно принимать решения о следующем шаге. Поэтому обучение машин игре требует долгой упорной работы, большого количества данных, а также разработки сложных алгоритмов, которые могут решать все появляющиеся в игре задачи.

Дэвид Сильвер, главный научный сотрудник DeepMind, объяснил на недавней пресс-конференции, что существует 10^26 возможных вариантов для каждого хода, и, возможно, тысячи таких вариантов за одну игру.

В этих условиях программе по искусственному интеллекту крайне сложно освоить Starcraft II, сказал Ориол Виньялс. В игре не существует универсальной стратегии, которая бы приводила к выигрышу во всех или в большинстве случаев — ее ИИ мог бы довольно быстро выучить и имитировать. Ситуация, как отмечают авторы, скорее напоминает игру «Камень-ножницы-бумага», когда существует несколько стратегий, каждая из которых сильна против другой, но не против всех сразу.

В качестве тренировочного датасета разработчики использовали предоставленные компанией Blizzard анонимизированные записи игр настоящих людей. Когда обученная на этих играх нейросеть научилась побеждать встроенные алгоритмы StarCraft II на самой высокой сложности в 95% случаев, создатели заставили программу играть с самой собой в течение двух недель.

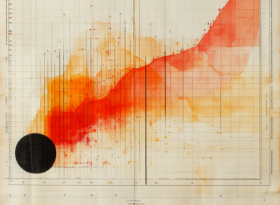

Весь процесс обучения занял 44 дня, после чего алгоритму удалось обыграть 99,8 процента игроков из около 90 тысяч официально зарегистрированных.

Как указывают в своей работе Виньялс и соавторы, наработки, позволившие сделать успешного в StarCraft бота, могут пригодится для управления роботами, личными помощниками, автономным транспортом и вообще повлиять на будущее ИИ.

Помимо достижений в игровой индустрии, превосходство AlphaStar может оказаться полезным в технологических нишах, в которых ИИ должен работать в условиях многозадачности, сотрудничать с многочисленными игроками, занимающимися одной и той же проблемой, и планировать будущее.

Сильвер говорит, что некоторые области применения включают создание лучших персональных помощников, которые помогут достичь поставленных целей, улучшение систем рекомендаций Google и более безопасные технологии автономного вождения автомобиля, хотя эти приложения могут появиться далеко будущем.

Сильвер и Виньялс отметили, что программа AlphaStar может быть использована для обучения операторов роботов, а затем, может быть, однажды и роботизированных рук.

Джордж Цибенко профессор инженерии Дартмутского колледжа, занимающийся исследованиями в области машинного обучения и нейронных вычислений, согласен, что алгоритмы AlphaStar могут дать значительный импульс развитию рекомендательных систем.

Рекомендательные системы стремятся отслеживать действия пользователей и предсказывать, что они хотели бы делать дальше. Наиболее известными примерами таких систем являются функции рекомендаций в Amazon и широко известный алгоритм YouTube. ИИ, способный быстрее учиться и адаптироваться к предпочтениям пользователей, окажется лучше существующих систем.

Однако Цибенко поспешил предостеречь от излишнего оптимизма в отношении применимости AlphaStar.

"Такие игры, как "StarCraft II" - это "закрытые миры" в том смысле, что правила фиксированы, цели игроков четко определены и так далее", - сказал он Business Insider. То же самое не относится к приложениям "открытого мира", таким как автономное вождение, кибербезопасность, военные операции, финансы и торговля и т.д.".

По словам Цибенко, лучше сосредоточиться на непосредственном применении нового ИИ DeepMind в областях, где среда сильно ограничена и оператор ИИ может контролировать, как игроки взаимодействуют с ним - скажем, робототехника в контролируемой и ограниченной производственной среде.